本文主要提供testtokenspped4ollama.py测试代码和testtokenspped4api.py测试代码,前者用于直接访问ollama API进行测试,后者只需符合OpenAI API格式即可测试,两者测试内容都是5道题目,最终输出一个结果文件,方便获得输出内容以及速度结果。

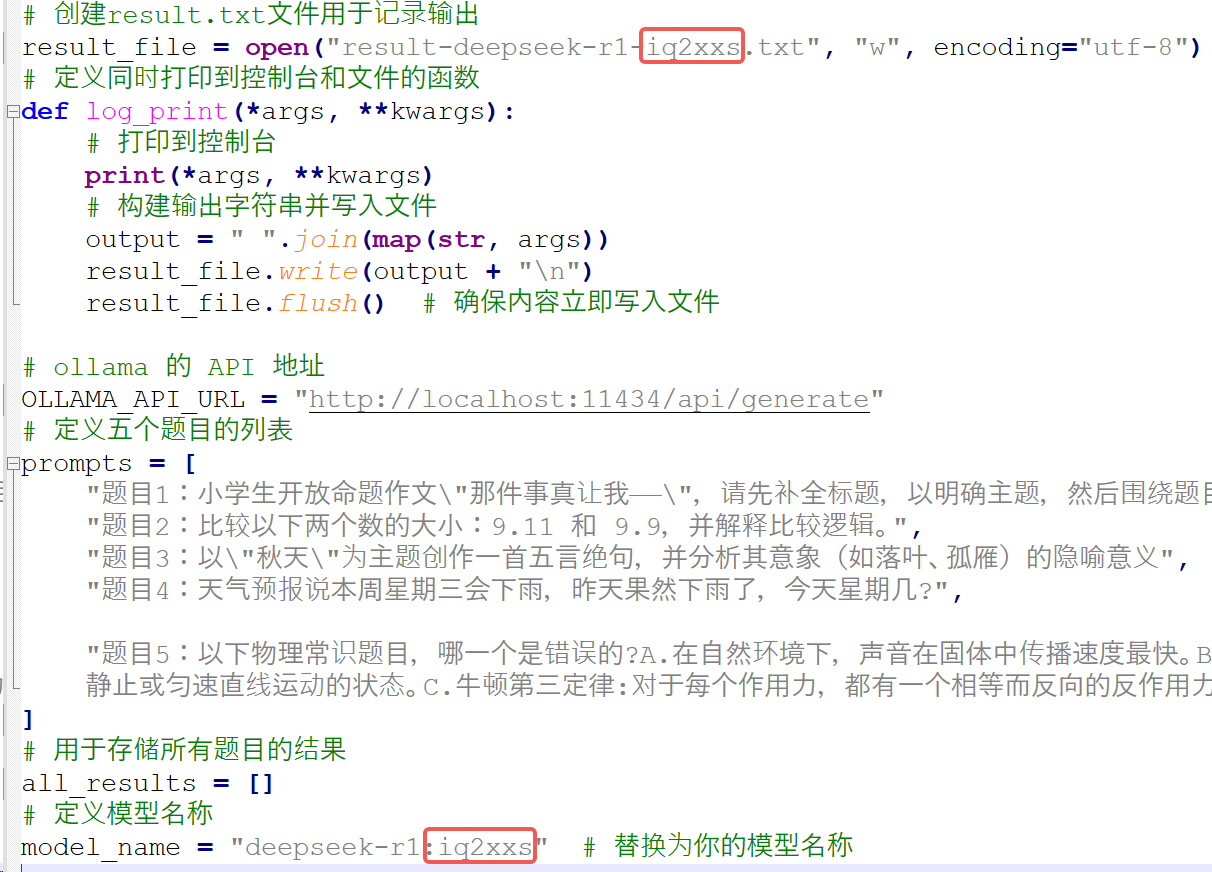

testtokenspped4ollama.py:用来测试ollama输出速度的python文件。一般本地跑ollama主要使用此代码。

testtokenspped4api.py:测试API输出速度的python文件。可用于公开API,我后来测试chat和reasoner的API就是此代码,原则上LM Studio输出openAI标准API应该也能测试,待后续尝试。

result-deepseek-chat.txt:deepseek的chat API输出的结果文件。

result-deepseek-reasoner.txt:deepseek的Reasoner API输出的结果文件。

注意:实际上这也是请AI写的代码,自己也可以直接使用cursor尝试,我提供的仅仅是方便大家偷懒。也可以查看我以前分享的代码:大模型token输出速度测试代码分享,来评估一下你的大模型性能吧! 本次提供的两个文件仅仅更好用了。

仅需修改上述两处就可以开始测试自己对应的模型啦。更具体的说明请见说明文档。

个人自行测试的文章“两千元服务器跑671B大模型:能跑,看你想要什么。”